はじめに

最近よく聞く「AI」。文章を書いたり、絵を描いたりとっても賢いですよね!でも、時々AIが間違った情報や、まるで「うそ」みたいなことを言っちゃうことがあるんです。これを「幻覚(ハルシネーション)」って呼びます。

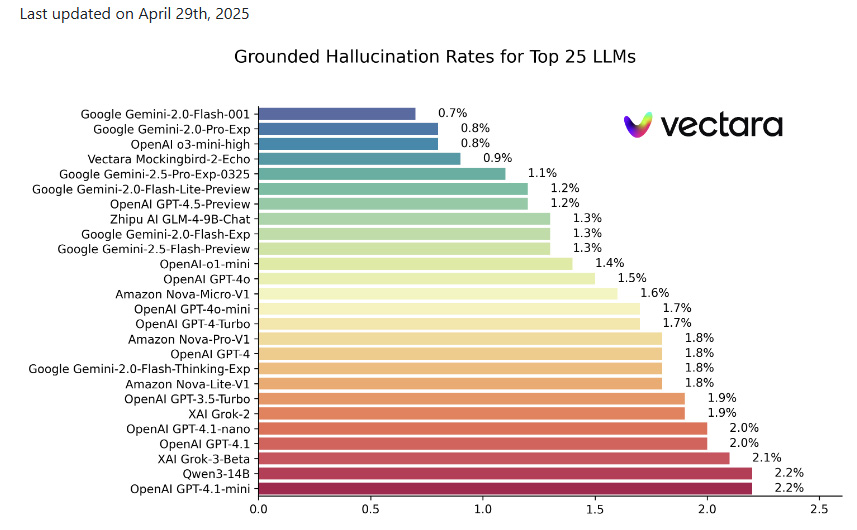

このAIの「うっかりミス」、AIが進化するにつれてどう変わってきているんでしょうか?今回は、Vectara社が公開している「Hallucination Leaderboard」というAIモデルの幻覚発生率ランキング(2025年4月29日更新データ)を元に、AIモデルが公開された時期と幻覚の起こしやすさに関係があるのか解説していきます。

AIの「幻覚」ってなんだろう?

AIの幻覚とは、AIが学習したデータや指示された情報には含まれていない、事実と異なる情報や、文脈に合わない内容を生成してしまう現象のことです。これが起こると、AIが出した情報の信頼性が下がってしまったり、私たちが間違った判断をしてしまう可能性もあるので、とても重要な問題なんです。

実は、専門家の研究によると、AIが幻覚を完全になくすのは数学的に難しいとも言われています。だから今の技術では、幻覚をゼロにすることよりも、いかに少なく抑えるか、うまく付き合っていくかが大切なんですね。

AIの「正直さ」を測るテスト?Vectara Hallucination Leaderboard

今回参考にした「Vectara Hallucination Leaderboard」は、AIモデルたちがどれくらい「正直」か、つまり幻覚を起こしにくいかを測るためのテスト結果ランキングのようなものです。特にこのリーダーボードでは、「AIが情報をでっち上げずに、どれだけ正確に文章を要約できるか」という点に注目して評価しています。

評価には「HHEM(Hughes Hallucination Evaluation Model)」という特別なモデルが使われています。これは、AIが作った要約文が、元の文章と比べて事実に基づいているかをチェックする仕組みです。具体的には、短い文章をAIに要約させて、その要約が元の文章の内容から逸脱していないか、余計な情報を加えていないかなどを厳しく評価します。

新しいAIほど「正直」になってる?

さて、本題です。新しいAIモデルほど、幻覚を起こす確率は低くなっているのでしょうか?

リーダーボードのデータを見てみると、全体的な傾向としては、公開時期が新しいモデルほど幻覚発生率が低いようです。つまり、技術の進歩とともにAIはより「正直」になってきていると言えそうです。実際、最新のモデルの中には、幻覚率が1%未満という驚くべき成果を上げているものもあります。これはほんの1年前には考えられなかったことです!

ただし、この傾向は絶対的なものではありません。いくつかの興味深い例外も見られます。

- 賢すぎるAIの悩み?:例えば、非常に高度な「推論(物事を筋道立てて考える力)」を持つように設計されたAIモデルが、かえってこの「文章要約テスト」では元の文章から少し逸脱した解釈をしてしまい、幻覚と判定されるケースがありました。他の場面では役立つ賢さが、このテストでは裏目に出ることもあるんですね。

- 得意分野の違い:AIにも得意なこと、苦手なことがあります。文章を正確に要約するのが得意なAIもいれば、創造的な文章を作るのが得意なAIもいます。このテストは「正確な要約」を測るものなので、その点も結果に影響しているようです。

他にも幻覚率に影響するポイントは?

AIモデルの公開時期だけでなく、他にも幻覚の起こしやすさに影響する要素がありそうです。

- 開発者の戦略:GoogleやOpenAIといった大手AI開発企業のモデルは、一貫して幻覚率が低い傾向にあります。また、Vectara自身のモデルのように、特定のタスク(この場合は要約)での幻覚削減に特化して開発されたモデルも好成績を収めています。

- AIの「規模」:一般的に、より大規模な(たくさんのデータで学習した、より複雑な構造の)AIモデルの方が、幻覚を起こしにくい傾向があると言われています。新しいモデルは、より大規模であったり、より多くのデータで学習されていたりすることが多いので、これも幻覚率低下の一因かもしれません。

- 「お試し版」モデルの性能:リーダーボードには「プレビュー版」や「試験版」といったタグが付いたモデルも多く掲載されています。これらは開発途中のモデルですが、それでも非常に低い幻覚率を達成しているものもあり、次世代AIのポテンシャルの高さを示しています。

この調査の注意点も知っておこう!

今回の分析結果を見る上で、いくつか知っておいてほしい注意点があります。

- テストの特性:このリーダーボードの評価は、あくまで「短い文章を、元の文章に忠実に要約する」という特定のタスクに基づいています。AIが詩を書いたり、複雑な質問に答えたりするような、他の種類のタスクでは結果が異なる可能性があります。

- 「公開日」のいろいろ:AIモデルの「公開日」といっても、開発者向けの先行公開だったり、一般ユーザーが使えるようになった日だったり、特定のバージョンアップの日だったりと様々です。そのため、単純な日付だけで比較するのは少し難しい面もあります。

- AI業界は日進月歩!:AIの技術はものすごいスピードで進化しています。今日の結果も、明日にはまた新しいモデルが登場して塗り替えられているかもしれません。

ポイント:このリーダーボードは、AIが「与えられた情報だけを使って、どれだけ正確にまとめられるか」を見ています。だから、自由な発想で文章を作ったり、幅広い知識を組み合わせたりするのが得意なAIでも、このテストでは「ルール違反」と見なされてしまうことがあるんです。

まとめ:AIの「うっかり」は減ってるけど、賢い付き合い方が大事!

Vectara Hallucination Leaderboardのデータから、AIモデルの幻覚発生率は、新しいモデルほど低くなる傾向があることが分かりました。これは、AI技術が着実に進歩し、より信頼性の高いものへと進化している証と言えるでしょう。

しかし、AIの種類や得意なこと、そして評価するタスクの内容によって、その「正直さ」は変わってきます。特定のテストで優秀だからといって、どんな場面でも万能というわけではありません。

私たちユーザーにとっては、AIが何を得意とし、どのような点に注意が必要なのかを理解した上で、賢く活用していくことがますます重要になりますね。AIの「うっかりミス」は減ってきていますが、最終的な判断は人間がしっかりと行う、という姿勢も大切です。

これからもAIの進化から目が離せません!